Speech Emotion Recognition (SER) : un outil de détection des émotions basée sur la voix via l’intelligence artificielle

La genèse du projet

Axys, cabinet de conseil en transformation durable agit principalement sur 3 leviers : la technologie, l’humain et les organisations. L’innovation et la proximité clients sont également au cœur de nos recommandations. C’est pourquoi nous avons créé en 2018 un laboratoire IA qui a pour vocation de co-créer des solutions d’IA avec et pour nos clients.

Parmi ces solutions, le Smart Report est l’innovation ayant concentré le plus d’effort de nos équipes ! Il s’agit d’un outil réalisant des transcriptions de conversations et de réunions, ainsi que leur synthèse. Si sur la transcription, la qualité est bien adaptée au contexte (ex. les acronymes et sigles spécifiques à chaque entreprise), la synthèse était en revanche plus difficile à mettre en œuvre et a pris un réel tournant qualitatif avec l’essor des LLM.

Le 1er objectif de cet outil était donc de servir notre efficacité opérationnelle car nos consultants réalisent très fréquemment des comptes-rendus. Il était également destiné à nos clients, principalement les centres d’appels. Nous avons alors pu constater des besoins de transcriptions littérales que nous ne soupçonnions pas comme les réunions des instances représentatives du personnel.

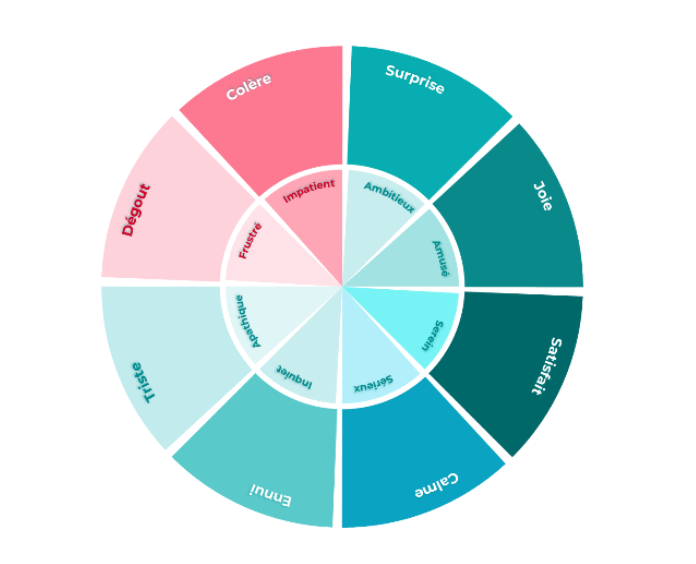

Pour compléter cette suite logicielle, nous avons alors décidé de développer une détection des émotions dans les conversations. Dans le cadre de nos missions, l’apport visé était multiple :

- Détecter des états émotionnels lors des ateliers avec nos clients. Cette connaissance nous permet ensuite de mieux cibler les personnes et les actions de conduite du changement

- Améliorer l’efficacité des centres d’appels en définissant des scripts pour les opérateurs pour qu’ils génèrent le plus possible de satisfaction clients

Le rôle d’Axys

Axys s’est associé avec le LISN, laboratoire en Science du Numérique, pour mener cette recherche. Nous avons alors conduit des recherches dans le cadre d’une thèse de Speech Emotion Recognition. Cette thèse a pour but de définir un système de reconnaissance des émotions en s’intéressant à l’acoustique et à la sémantique.

Le laboratoire nous a appuyé dans ces travaux avec une infrastructure comme Jean Zay, le super calculateur français, et oriente nos recherches grâce à des précédentes recherches menées sur les émotions et l’IA.

Nous nous appuyons également sur d’autres acteurs externes :

Easy2Call, centre d’appels spécialisé dans l’accompagnement des business travelers face à leurs problématiques de réservation d’hôtel, voiture, avion, train.

Nijta, afin de mettre en conformité nos enregistrements avec la règlementation RGPD, en anonymisant les dialogues.

Principales étapes de la recherche :

La 1ère étape a consisté à obtenir un corpus de conversations. Ce fut chose faite grâce à notre partenaire centre d’appels.

Nous avons ainsi obtenu 470 conversations représentants environ une trentaine d’heures. Ensuite, est venu le temps de l’annotation. C’est un process qui vise à définir les émotions associées à chaque conversation. Mais avant cela, il a fallu définir le type d’annotation et la méthode :

- Le type : labélisation des conversations ou annotation en continu. Nous avons choisi la méthode continue pour identifier les changements d’états émotionnels.

- La méthode : annotation directe de chaque instant ou 2 composantes de l’acoustique : l’arousal et la valence.

Afin de mener l’annotation du corpus, nous avons sélectionné les conversations avec le plus d’énergie pour limiter le travail important et couteux de l’annotation. L’analyse de chaque instant de chaque conversation a été réalisée par des étudiants en psychologie. Cette phase a généré de nombreux débats sur la subjectivité des émotions. Nos recherches nous ont conduit à prendre en compte la sensibilité de chaque annotateur et faire une moyenne. Le système est beaucoup plus performant ainsi. Nos annotateurs ont aussi évalué l’empathie client et opérateur, la satisfaction du client, le degré d’urgence pour une labélisation globale des conversations.

Résultats :

Les résultats d’un point de vue scientifiques sont très satisfaisants. Ils permettent de prédire les dimensions arousal (intensité acoustique) et valence (tonalité positive / négative) avec une bonne précision.

D’un point de vue scientifique, cela a nécessité de lever les challenges liés à l’annotation : latence entre l’acoustique et l’annotation, subjectivité et dépendance de l’annotation à la sensibilité des annotateurs, taille des segments d’annotation, diarisation, c’est-à-dire la séparation des tours de parole, les nombreuses conversations se déroulant sur un ton neutre, etc.

Le système a également permis de mettre en avant l’importance de l’empathie et l’implication de l’opérateur dans la satisfaction du client. Ces variables sont en effet très fortement corrélées. Donc, si nous avons un message à passer aux centres d’appels, c’est de travailler sur l’empathie de leurs opérateurs.

Le principal avantage de notre système est la capacité à détecter des émotions dans un contexte réel. Les précédentes recherches étaient basées sur des corpus joués et même surjouées par des acteurs. Avec nos conversations réelles, nous arrivons à mieux discerner les états émotionnels.

Minimum Marketable Product

Nous avons lançé un MMP (Minimum Marketable Product, soit une version béta). Ce MMP complète la suite Smart Report lancé, il y a quelques années. Il propose comme fonctionnalités principales :

- La transcription des conversations téléphoniques

- La synthèse de ces conversations (participants, dates, relevé d’information et prochaines actions)

- Le fil de l’état émotionnel au cours de la conversation, avec la possibilité d’effectuer un focus sur des instants précis fortement émotionnels

- Encore incertain pour le MVP : niveau d’empathie et de satisfaction clients

Ce MMP a été déployé en phase de tests sur un panel d’utilisateurs. Cette phase de tests nous permettra de définir l’intérêt client et les prochaines orientations en termes de roadmap.

Intérêt du MMP

Le MMP a un intérêt pour les centres d’appels car il a été conçu en fonction de leurs besoins (améliorer les scripts à partir de l’analyse émotionnelle, intervenir en cas d’appels fortement négatif, analyser la satisfaction clients sur tous les enregistrements à moindre coût, analyser le niveau de fatigue des opérateurs, etc.).

Mais ce serait se tromper que de n’envisager que ces cibles. Les autres usages courants ou expérimentés de la détection sont :

- L’automobile pour adapter l’ambiance

- Les cours collectifs (pour mesurer le niveau de participation et améliorer les cours). C’est une expérimentation réalisée en Chine

- Les bots ou tout IA GEN pour adapter les réponses en fonction de l’émotion perçue

Envie d’en savoir plus ?

Que peut vous apporter un cabinet de conseil ?

La transformation de votre organisation est un défi complexe qui demande une vision stratégique, des compétences spécifiques et une réactivité sans faille.

Axys s’engage à répondre à vos besoins dans les plus brefs délais et à vous fournir des solutions personnalisées, adaptées à vos enjeux spécifiques.