Marketing A/B Testing : Comment s’y prendre ?

72% des entreprises considèrent que l’optimisation de l’expérience utilisateur est une priorité. Pour mettre la théorie en pratique, nous avons besoin d’une méthodologie robuste. Voyons maintenant ce que nous pouvons faire en parcourant les principales étapes de l’ A/B testing.

1ère étape : l’analyse de la performance

Découvrir ce qui compte vraiment est la première étape pour un test efficace.

Trouver votre audience

Avant de mettre en œuvre des actions, vous devez identifier le chef de projet pour le processus de mise en œuvre et de reporting des tests, ainsi que les propriétaires de données pour la configuration des examens et des tests techniques.

Conseils : Intégrez le processus de reporting avec votre comité de pilotage de la performance / business.

Déterminer vos objectifs

Il est important de définir au préalable les bons objectifs et KPI avant de se lancer dans l’audit de performance de votre site web et identifier les problèmes issus de l’analyse basée sur les objectifs ci-dessous.

- Quels sont vos objectifs business ?

- Acquérir de nouveaux leads et les convertir en opportunité business

- Quels sont les objectifs de votre site web ?

- Acquérir du trafic de qualité

- Convertir le trafic en lead

- Quels sont vos KPI ?

- Nombre d’utilisateurs

- Nombre de leads

- Taux de conversion

- Coût d’acquisition par lead

- Quels sont vos objectifs ?

- Une augmentation de 20% de vos volumes de ventes, une amélioration de 5% de votre taux de conversion…

Que cherche-t-on à mesurer ?

En premier lieu, il faut réaliser un rapport permettant de visualiser la performance globale du site et ensuite analyser le trafic par page (source de trafic, pages d’entrée/sortie, taux d’abandon de panier), ainsi que les indicateurs UX (ergonomie des pages, arborescence du site, vitesse de chargement des pages, design du site…).

« Ce que vous ne pouvez pas mesurer, vous ne pouvez pas l’améliorer »

William Thomson Mathématicien anglais (1824-1907)

Comment analyser la performance de son site ?

L’Utilisation d’un outil de web analytics permet de sauvegarder les statistiques de votre site, de mesurer le nombre de visiteurs, calculer la durée des visites, obtenir la répartition géographique des visiteurs… mais ce n’est pas tout ! Il vous offre également la possibilité d’évaluer la performance de vos actions.

Il existe une multitude d’acteurs sur le marché. Il y a ceux dont les outils sont gratuits comme Google Analytics ou AWStats et ceux dont les outils sont payants à l’instar de WebTrends, XITI, ou encore Omniture…

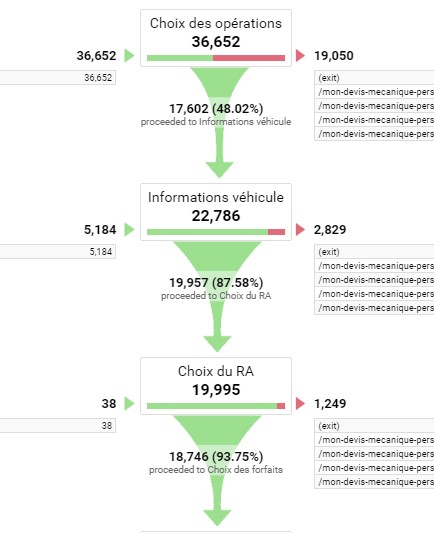

Les outils de web analytics vous permettront de visualiser simplement le tunnel de conversion de chacune de vos pages afin de trouver la partie problématique du site.

L’expérience utilisateur ou UX (User eXperience en anglais) doit également être analyser. Elle désigne la qualité de l’expérience vécue par l’utilisateur dans toute situation d’interaction. L’UX qualifie l’expérience globale ressentie par l’utilisateur lors de l’utilisation d’une interface/

Cette dernière permet de comprendre plus en détails le comportement de vos internautes, d’obtenir des informations supplémentaires (mouvement des yeux, de la souris…), identifier et corriger les points bloquant la conversion ou encore d’optimiser la « satisfaction-utilisateur ».

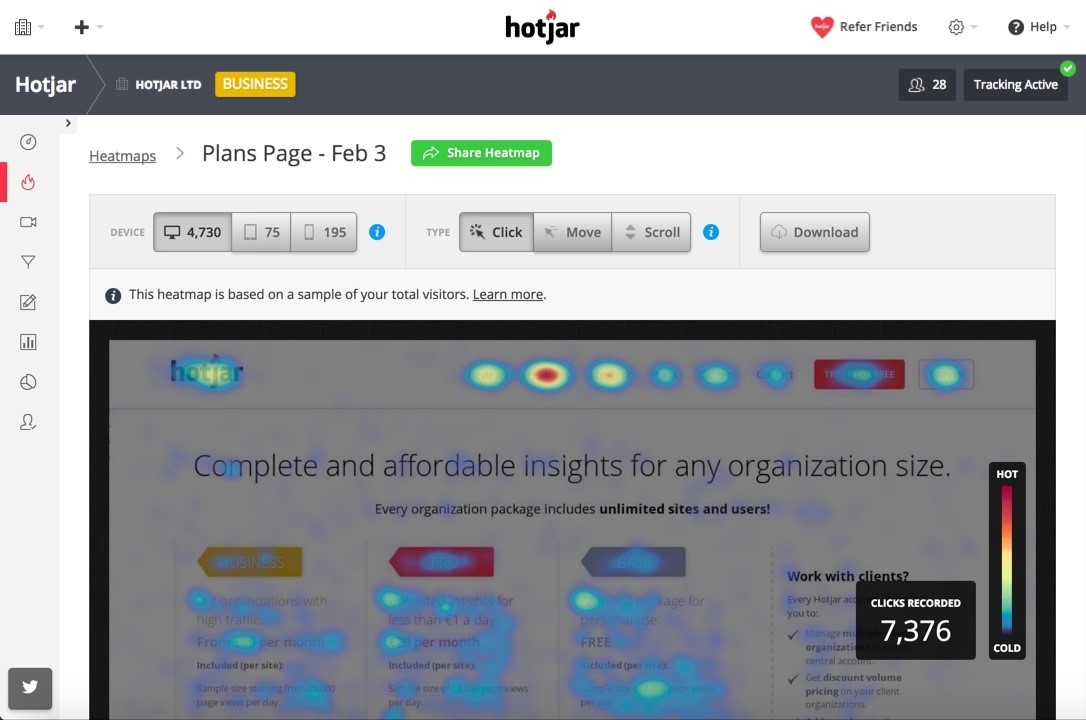

Un des plus célèbre outils UX, Hotjar, permet de relever les « points chauds » correspondant aux endroits où les internautes cliquent le plus (heatmaps), d’enregistrer les interactions entre l’internaute et une page Web : clic, scroll, mouvements de la souris (Visitor Playback), mettre mettre à l’épreuve la circulation d’une page à une autre à travers des entonnoirs de conversion (conversion funnels) et propose des enquêtes à vos internautes pour relever les points bloquants (survey).

Les possibilités qu’offre l’analyse comportementale est quasi infinie. Vous pouvez également mesurer et optimiser l’engagement et la conversion de vos formulaires en découvrant quels champs sont trop longs à remplir, lesquels sont laissés en blanc et pourquoi vos visiteurs abandonnent le formulaire et la page..

Le kit de démarrage

- Exécutez l’analyse technique sur toutes les pages : test croisé, inter-appareil et test de vitesse pour vous assurer que le site est en bonne condition pour exécuter les tests A/B.

- Vérifier si les tags de tracking sont bien implémentés : un tag de Google Analytics et un tag de l’outil générant des heatmaps.

- Intégrez le processus de reporting avec votre comité de pilotage de la performance.

- Catégorisez les rapports sur différents navigateurs, appareils (bureau / mobile) et produits (avec différents entonnoirs de conversion).

2ème étape : Priorisation des tests

Avec des ressources limitées, priorisez tous les tests potentiels et choisissez ceux qui ont le plus d’impact.

Pour bien commencer cette phase, classez par ordre de priorité les pages à tester en notant les performances des KPI de l’analyse précédente :

- Priorisez les pages ayant une grande importance pour le trafic : pages les plus visitées, pages d’entrée…

- Priorisez les pages présentant un fort potentiel d’amélioration de conversion : les pages de sortie les plus performantes, les pages présentant des taux d’abandon élevés…

Ensuite, faites un brainstorming sur toutes les hypothèses du test sur la ou les pages prioritaires, par exemple : « ajouter un autre bouton CTA (Call To Action) en bas de la page pour augmenter le taux de conversion sur une page de demande de devis… »

Enfin, commencez à évaluer et prioriser toutes les hypothèses du test.

La priorisation des tests A/B sur la page choisie est un système de notation pour classer toutes les hypothèses de tests possibles en termes de :

- Visibilité: le changement est-il au-dessus de la ligne de flottaison ? Visible en 5 secondes ?

- Impact sur les performances : le test s’exécute-t-il sur une page à trafic élevé avec un taux de sortie élevé ? Est-ce susceptible d’augmenter le taux de conversion ?

- Analyse prise en charge : l’analyse avant / après des tests est-elle prise en charge par l’analyse ou l’analyse de suivi de la souris ?

- Aspect pratique : le test peut-il être suffisamment efficace pour être mis en œuvre ?

L’hypothèse des tests avec les scores totaux les plus élevés sera priorisée pour fonctionner.

Mais comment réaliser cette priorisation ?

Avec des ressources limitées, donnez la priorité à tous les tests potentiels et choisissez ceux qui ont le plus d’impact.

Où tester ?

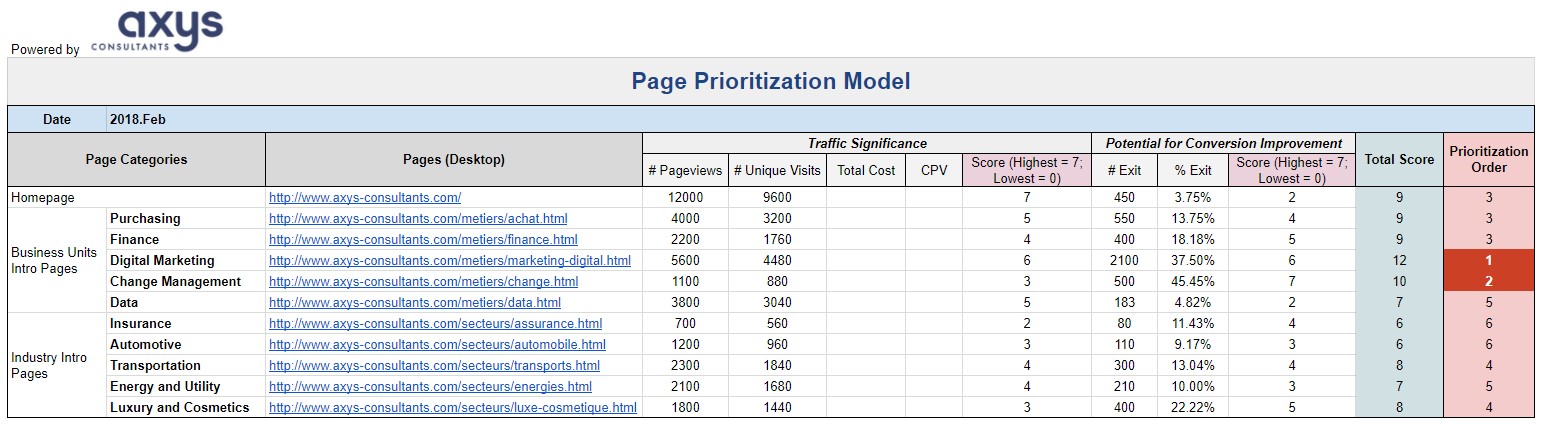

Tout d’abord, nous devons hiérarchiser les pages à tester à l’aide des résultats d’analyse présentés à l’étape 1. Gardez à l’esprit deux principes à l’aide de l’exemple de modèle de hiérarchisation ci-dessous:

- Donner la priorité aux pages à fort trafic : pages les plus visitées, premières pages d’arrivée, pages avec visites coûteuses

- Donner la priorité aux pages présentant un potentiel élevé d’amélioration de la conversion : premières pages de sortie, pages à taux de transfert en entonnoir élevé

Conseils : Séparez le processus de priorisation des pages par périphériques : Desktop / Mobile.

Faites attention aux catégories de page lorsque vous attribuez des scores à chaque KPI : ex. Pour un pourcentage élevé de sortie (indiquant un fort potentiel d’amélioration de la conversion) de la « page de remerciement », nous devrions attribuer un score faible, car il s’agit déjà de la fin de l’entonnoir de conversion.

Ce qui pourrait être testé

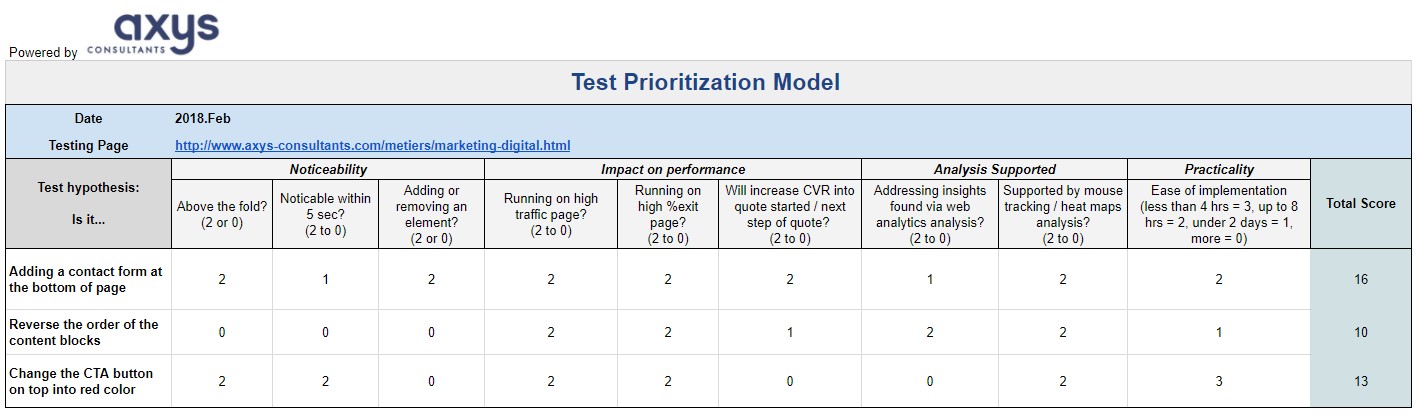

Après avoir hiérarchisé les pages sur lesquelles exécuter les tests, l’étape suivante consiste à réfléchir et à répertorier toutes les hypothèses de test, par exemple: «l’ajout d’un formulaire de contact au bas de la page / metiers / marketing-digital augmentera la CR. de visites en pistes ».

Que tester ?

Après avoir répertorié toutes les hypothèses de test, il est temps d’évaluer et de hiérarchiser les hypothèses de test. Voici un système de notation utile pour classer toutes les hypothèses de tests possibles en termes de:

- Perceptibilité : le changement est-il au-dessus du pli ? Visible en 5 secondes ?

- Impact sur les performances : le test fonctionne-t-il sur une page à trafic important avec un taux de sortie élevé ? Est-il susceptible d’augmenter le CVR ?

- Analyse prise en charge : l’analyse avant / après des tests est-elle prise en charge par l’analyse ou l’analyse de suivi de la souris ?

- Aspect pratique: le test peut-il être suffisamment efficace pour être mis en œuvre ?

L’hypothèse de test avec les scores totaux les plus élevés sera priorisée.

Conseils :

- Contrôlez le nombre de tests A/B choisis (sur la même page ou sur des pages différentes) au cours de chaque période de test (environ 3 semaines) sous 2.

- Pour utiliser le modèle de hiérarchisation : Le premier onglet concerne la hiérarchisation des pages avant de choisir les tests détaillés; puis créez des onglets distincts pour chaque page choisie pour la priorité de test (par exemple, la page de test 1).

- Communiquez avec les personnes responsables des opérations de test, des analyses et de la configuration technique pour vous assurer que les tests soient réalisables

Étape 3 : Tester

Une bonne configuration et planification des tests aide à faire un bon test.

Sélectionnez votre type de test

Première question à se poser, devrions-nous faire des tests fractionnés A / B / N ou des tests multivariés (MVT) ?

Voici quelques critères qui pourraient vous aider à choisir entre le test fractionné A/B et le test multivarié :

Objectifs généraux :

- Pour tester les modifications partielles du site Web, il est préférable d’utiliser le test de fractionnement A / B / N

- Pour tester une nouvelle interface avec des modifications d’éléments combinées, Test multivarié (MVT)

- Volume de trafic – Les tests multivariés ne concernent que les sites à trafic important

Choisissez un outil d’essai

Pour savoir quel type de test mettre en œuvre, il est également essentiel de choisir un outil de test. Voici quelques outils de test A / B tiers recommandés:

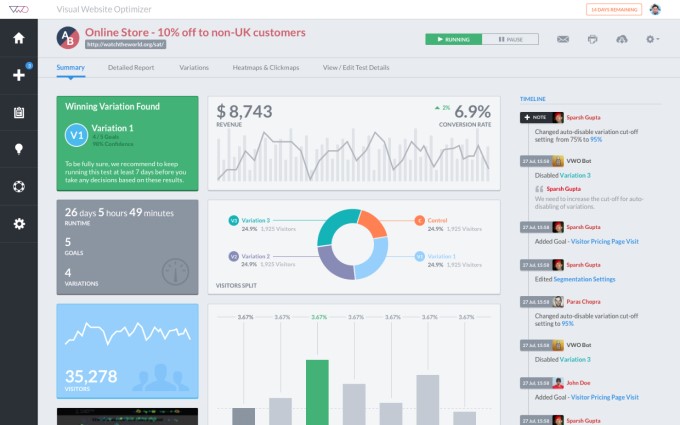

- Visual Website Optimizer

- AB Tasty

- Adobe Target

- Google Analytics (nécessité de disposer de pages / URL distinctes, pas de fonction installée pour la création de variantes)

Configurer vos tests

En général, le processus de test divise le trafic des sites Web entre différentes versions et mesure leurs performances, compare, puis sélectionne la version la plus performante à adapter.

Pour mettre en place une campagne de test sur l’outil choisi, nous pourrions procéder étape par étape:

- Sélectionnez le type de campagne de test (prenez comme exemple les tests A / B)

- Entrez l’URL de la page de test (la page sélectionnée à l’étape précédente)

- Créer des variantes (basées sur les tests prioritaires)

- Ajouter des objectifs de conversion (pour suivre les visites, les clics, les soumissions de formulaire, etc.)

- Estimer la durée de la campagne et allouer le trafic

- Ajoutez un code de suivi généré automatiquement sur toutes les pages de votre site Web

Conseils : Estimez la durée des tests et allouez le trafic en fonction du volume de trafic et du nombre de variations afin de vous assurer que chaque variante dispose d’un échantillon de trafic suffisant: il est suggéré d’allouer 50/50% pendant 3 semaines.

Mesurez votre test

Pour mesurer les résultats des tests, au moins 3 analyses doivent être effectuées au cours des tests:

- Analyse de contrôle technique (dans les premiers jours)

- Analyse à mi-test (pour éviter une forte baisse du trafic due au test d’échec)

- Analyse «Sunset» (pour conclure)

Étude de cas

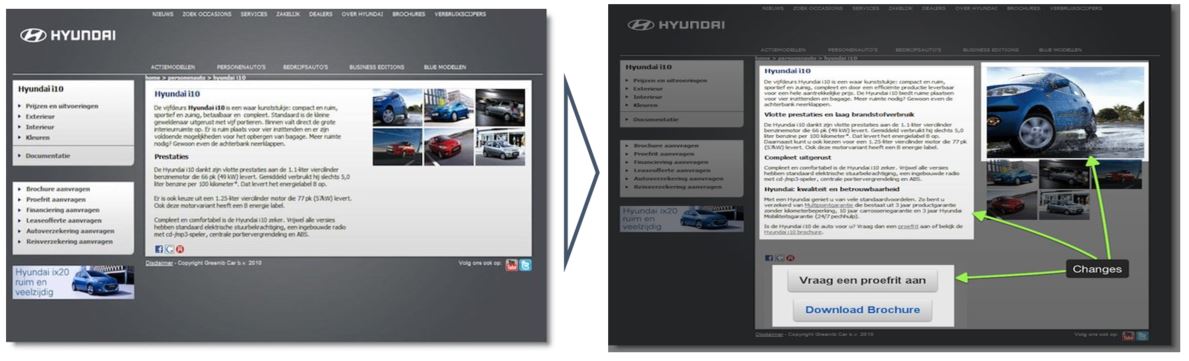

Une étude de cas de Hyundai :

Qu’est-ce qui a été testé ?

- Nouveau texte (convivial pour le référencement) versus texte de contrôle

- Boutons CTA supplémentaires contre aucun bouton supplémentaire

- Grande photo de la voiture par rapport aux vignettes

Un total de 8 combinaisons (3 sections, 2 variations chacune = 2 * 2 * 2) ont été générées pour ce test à plusieurs variables;

Les variantes gagnantes ont augmenté le taux de conversion (demande de test de conduite ou brochure) de 62% par rapport à ce test à plusieurs variables.

Étape 4 : Industrialisation

Apprenez de vos résultats et recommencez le processus.

Une fois les tests réalisés

Bien entendu, avec l’analyse «temporelle» des tests, nous devons tirer des conclusions et appliquer la version la plus performante. Voici un exemple de rapport d’analyse de performance de test :

Une bonne fois pour toute

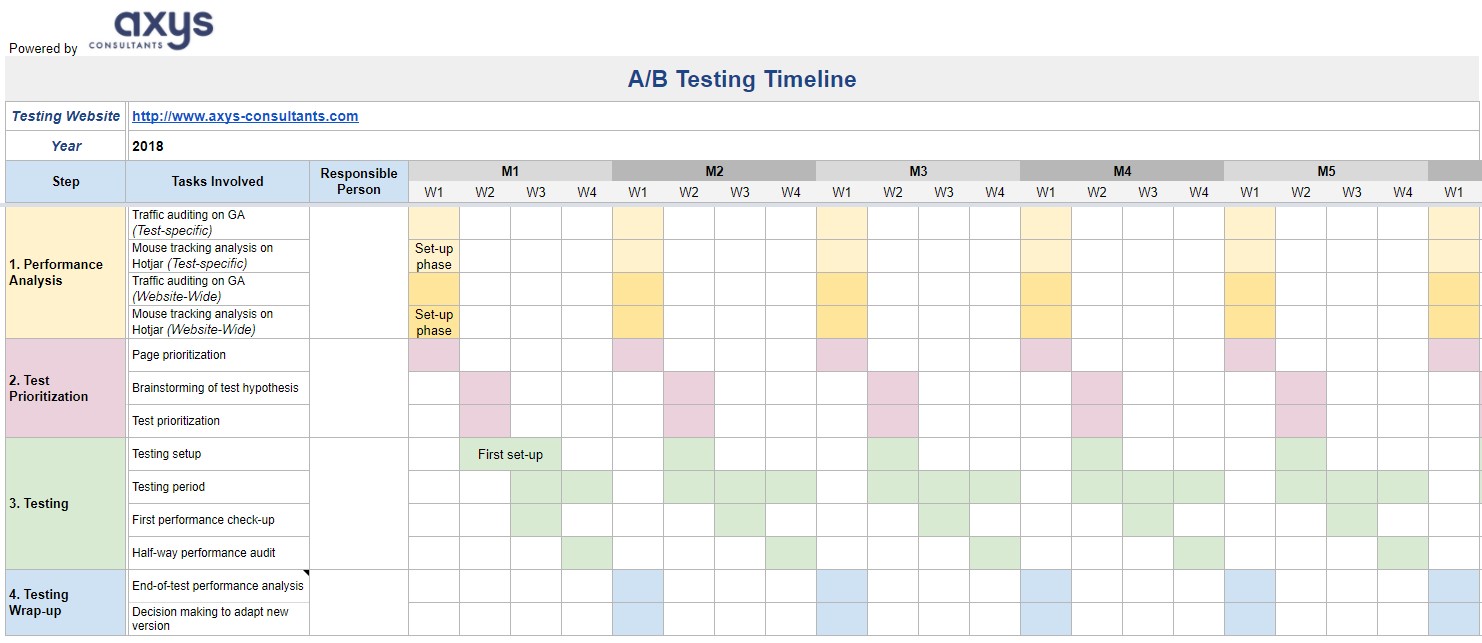

Pour industrialiser les efforts de test A/B, il est nécessaire de construire un calendrier opérationnel comprenant toutes les étapes allant de l’analyse du statu quo à la définition des priorités des tests, en passant par la configuration des tests jusqu’à la publication des résultats des tests et la prise de décision mensuelle :

- En intégrant les rapports de performance spécifiques aux tests à l’Analyse de performance Étape 1, nous pourrions structurer un rapport mensuel comprenant :

- Analyse de la performance du test : rapport détaillé de l’efficience et de l’efficacité du test, comme indiqué ci-dessus

- Analyse de performance du site Web : comparaison générale des performances du site Web / page avant / après les tests

- Nous vous recommandons également un modèle adaptable comme calendrier opérationnel pour toutes les tâches impliquées à toutes les étapes :

Cliquez ici pour utiliser l’exemple gratuit de chronologie opérationnelle des tests A / B.

Conseils :

Configuration des outils :

- Commencez au moins 1 semaine avant la « deadline » pour la première installation des outils d’analyse et de test;

- Communiquez à l’avance avec les développeurs de sites Web sur la question du code de suivi / marquage;

- Configurer l’outil de test pour chaque période de test suivante conformément au calendrier suggéré.

Adapter la chronologie si nécessaire en fonction des conditions de trafic (par exemple, si le volume de trafic est exceptionnellement trop bas, la période de test doit être prolongée)